Mit Hilfe von Metadaten können neue Prozesse geschaffen werden, die den sich wandelnden Kundenbedürfnissen gerecht werden, nicht nur in der Sicherheitsbranche, sondern auch im Bereich der Sicherheit und der digitalen Transformation. Nach dem Motto: Videos besser nutzbar und durchsuchbar machen!

Was sind Metadaten?

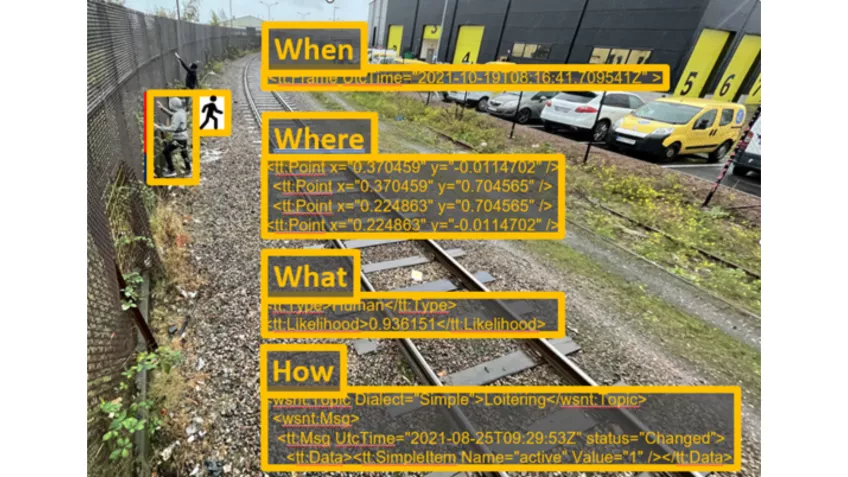

Metadaten sind Informationen über andere Informationen. In der Welt der Videosicherheit können Bilder mit Metadaten versehen werden. Im folgenden Beispiel sehen wir, dass Informationen über die Zeit, die Position im Bild, die Art des erkannten Objekts und das Ereignis (Herumlungern) als Metadaten generiert werden.

Die Metadaten können mit einer Wahrscheinlichkeit versehen werden. Diese Information wird auch an die „Benutzer“ dieser Metadaten weitergegeben und hilft, Objekte mit einem bestimmten Vertrauensniveau herauszufiltern.

Wie werden sie erstellt?

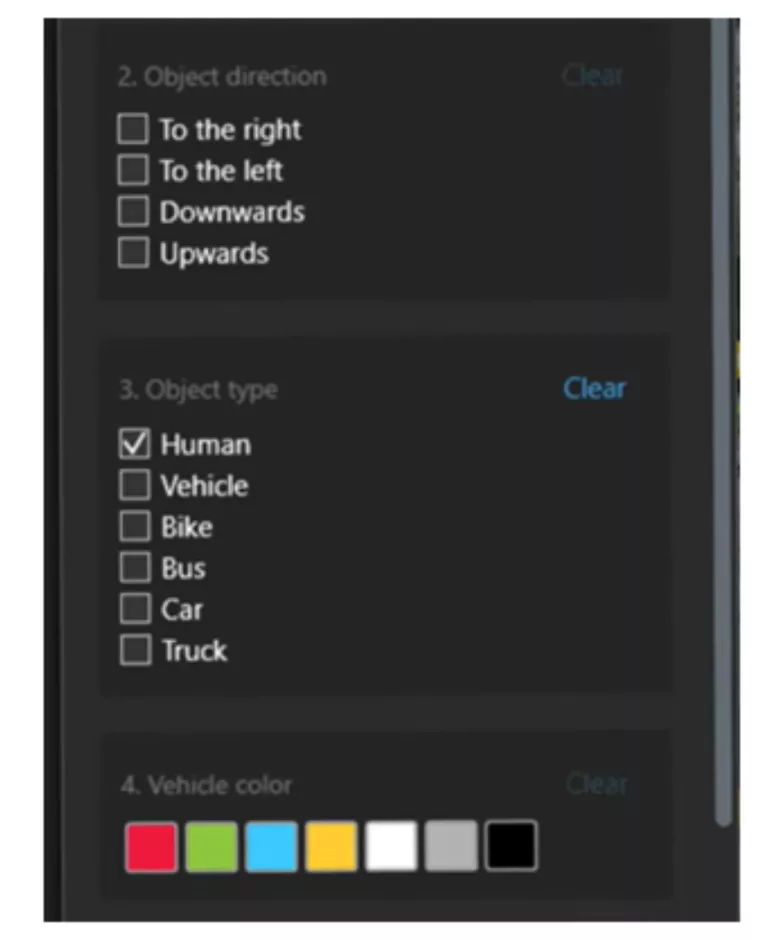

Mit Hilfe von KI werden sogenannte Modelle trainiert (Deep Learning), um verschiedene Arten von Objekten oder Situationen zu erkennen. Diese erkannten Objekte sind die Quelle der entsprechenden Metadaten. Klassische Objekte sind „Mensch“, „Fahrzeug“ (oder eine Untergruppe wie „PKW“, „LKW“), Nummernschild. Das Modell kann auch darauf trainiert werden, Objektattribute wie Farbe und Objektverhalten wie Flugbahn (Beispiel „von links“) zu erkennen, und all diese Informationen werden in Metadaten übersetzt. Nicht vergessen: Es besteht ein direkter Zusammenhang zwischen der Komplexität eines Anwendungsfalles und dem Trainingsaufwand des Modells.

Sobald die Modelle trainiert sind, erzeugt der resultierende Algorithmus kontinuierlich Metadaten. Für den „Nutzer“ der Informationen stellt sich die Frage, ob er eine „Einzelbild“- oder eine „konsolidierte“ Bereitstellung benötigt. Dies muss von Fall zu Fall entschieden werden. Bei der „konsolidierten“ Bereitstellung wird die an den Nutzer gesendete Datenmenge erheblich reduziert, indem Metadaten nur dann bereitgestellt werden, wenn Objekte in der Szene vorhanden sind. Weitere Informationen finden Sie in diesem White Paper.

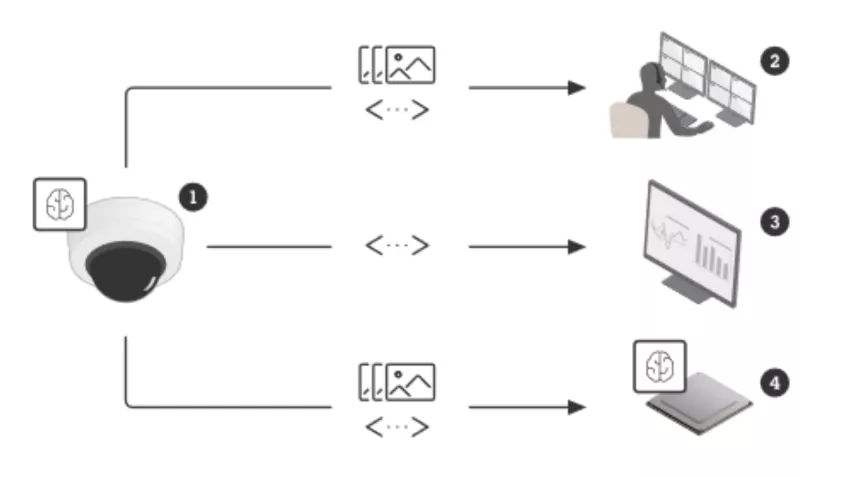

Durch die Weiterentwicklung der Hardware und die erhöhte Rechenkapazität der Kameras ist es nun möglich, trainierte KI-Modelle direkt in der Kamera in Deep Learning Process Units DLPU auszuführen und so Metadaten direkt in der Kamera „on the Edge“ zu generieren. Der ARTPEC-8-Chipsatz von Axis führt eine DLPU aus. Die Vorteile von Edge Computing? Einsparung von Servern! Analyse von Rohbildern (keine Kompression)! Echtzeit-Ereignisse möglich! Und in einigen Fällen kann man den Datenschutz gewährleisten und den Netzwerkverkehr reduzieren.

Wo werden die Metadaten verwendet?

Sobald die Metadaten erzeugt wurden, können sie entweder direkt von einer Anwendung verwendet werden, am besten in der Kamera aus den gleichen Gründen wie oben (Sie haben wahrscheinlich schon von AXIS Object Analytics gehört), oder sie können an Drittanbieter als Input für die weitere Verarbeitung weitergegeben werden.

Bei der Übertragung an Drittanwender erleichtern offene Standards wie ONVIF Profile M oder AXIS Scene Metadata und Protokolle wie eine offene API, RTSP oder MQTT die nahtlose Übertragung und Integration, einschließlich der Möglichkeit, Sensordaten in der Cloud zusammenzuführen, um bessere Einblicke zu erhalten. So können Sie das Potenzial Ihrer Daten voll ausschöpfen.

Mehrwert

Betrachten wir nun die vier Hauptverwendungszwecke der Metadaten:

- Direkt auf der Kamera durch Edge-Anwendungen:

Neben Axis-Anwendungen wie AXIS Object Analytics bieten auch unsere Technologie-Integrationspartner Edge-Anwendungen an. Ein Beispiel ist Aarani, die ihre Modelle auf die Erkennung von Rauch und Flammen trainiert haben. In Videomanagementsystemen (VMS), um automatische Reaktionen auf Alarme zu ermöglichen und eine schnelle forensische und Echtzeitsuche zu ermöglichen. Die folgende Abbildung zeigt ein Beispiel für Metadaten, die der Bediener im VMS auswählen kann, um effizient nach Objekten und Ereignissen zu suchen.

Quelle: Milestone - Gesammelt in IoT-Plattformen und visualisiert in Dashboards für Einblicke und Statistiken.

Sehen Sie sich die beeindruckenden Statistiken an, die Edeva in Statens Vegvesen (in der Nähe von Oslo) durch die Analyse von illegalem Linksabbiegen unter Verwendung der Metadaten eines Netzwerkradars (Fahrzeug, Linksabbiegen) und einer Kamera (Nummernschild) erstellt hat. - Von Entwicklern als Input für übergeordnete Analysen, die eine zweite Verarbeitungsebene hinzufügen.

Es ist auch realistisch, Modelle auf eine bestimmte Situation zu trainieren, zum Beispiel für die Qualitätskontrolle. Lesen Sie hier, was der Automobilhersteller BMW dazu entwickelt hat. Denkbar sind auch speziell trainierte Modelle, die analysieren, ob ein Behälter leer ist, oder die zählen, ob in einem industriellen Prozess die benötigte Stückzahl vorhanden ist.

Ausblick - was kommt als nächstes?

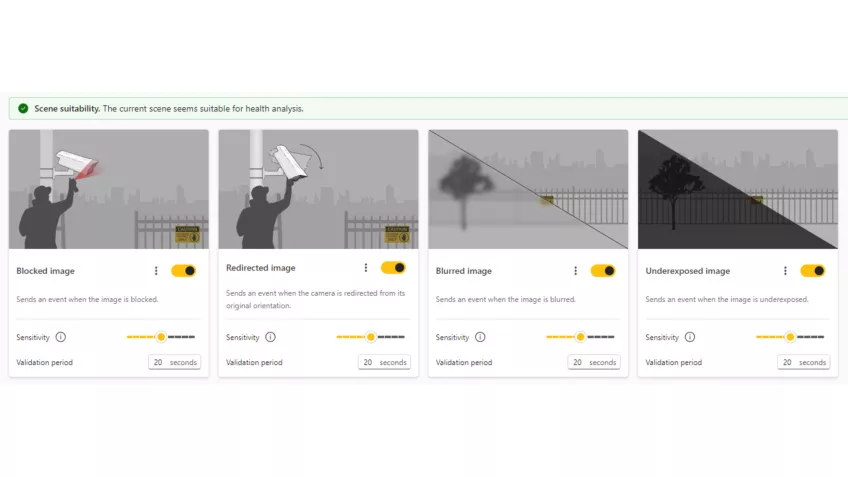

Jetzt: AXIS Image Health Analytics

Prüfen Sie die Verwendbarkeit des Videomaterials, bevor es zu spät ist! Neue Metadaten ermöglichen eine Warnung, wenn die Bildqualität beeinträchtigt ist (unscharf oder unterbelichtet) oder wenn die Kamera manipuliert wird (blockiert oder umgeleitet). Sie erzeugt Axis-Ereignisse und ist ONVIF-kompatibel.

In naher Zukunft:

Wie wäre es mit einer Kombination aus Metadaten und generativer KI (z. B. ChatGPT)? Stellen Sie sich folgende Frage vor, die ein Operator stellen könnte: „Zeige mir alle Klempnerfahrzeuge, die heute Morgen vorbeigefahren sind“. Die Suchmaschine würde die Videosequenzen schnell nach den Metadaten „heute morgen“ und „Fahrzeug“ auswählen, während die generative KI in den ausgewählten Sequenzen nach Fahrzeugen suchen würde, die einem Klempner gehören könnten. Fortsetzung folgt!

Zusammenfassung und Schlussfolgerung

- Metadaten werden durch KI-basierte, trainierte Algorithmen generiert. Sie helfen, Videos besser nutzbar und durchsuchbar zu machen.

- Der Erfolg der Analyse steht in direktem Zusammenhang mit dem Trainingsaufwand des Modells. Denken Sie daher an einfache Anwendungsfälle.

- Edge Computing ist dank leistungsfähiger Chipsätze die effizienteste und nachhaltigste Methode.

- Metadaten können direkt in Edge-Anwendungen verwendet oder an Dritte weitergegeben werden.

In diesem Sinne, bleiben Sie dran und ich wünsche Ihnen allen eine nachhaltige Planung von zielgerichteten und intelligenten Lösungen!

Ihr Jochen Sauer

Architect & Engineering Manager Deutschland

📞 +49 151 12 24 56 81

✉️ Jochen.Sauer@axis.com

🔗 XING | LinkedIn

PS: Wenn Sie ChatGPT fragen, wie ein Klempnerfahrzeug aussehen könnte: