Au cours de la dernière décennie, grâce à des années d'évolution, les progrès réalisés dans le domaine de l'analyse des données provenant des caméras de surveillance ont considérablement élargi les possibilités de transformer ces données en informations exploitables et en actions automatisées. L'analyse en périphérie est devenue un domaine très polyvalent et innovant, grâce à des caméras robustes équipées de capacités de traitement par IA.

Cette évolution a ouvert la voie à une nouvelle génération de performances analytiques. Pour approfondir ses avantages actuels et explorer son potentiel, nous avons discuté avec Mats Thulin, directeur des solutions d'IA et d'analyse chez Axis Communications.

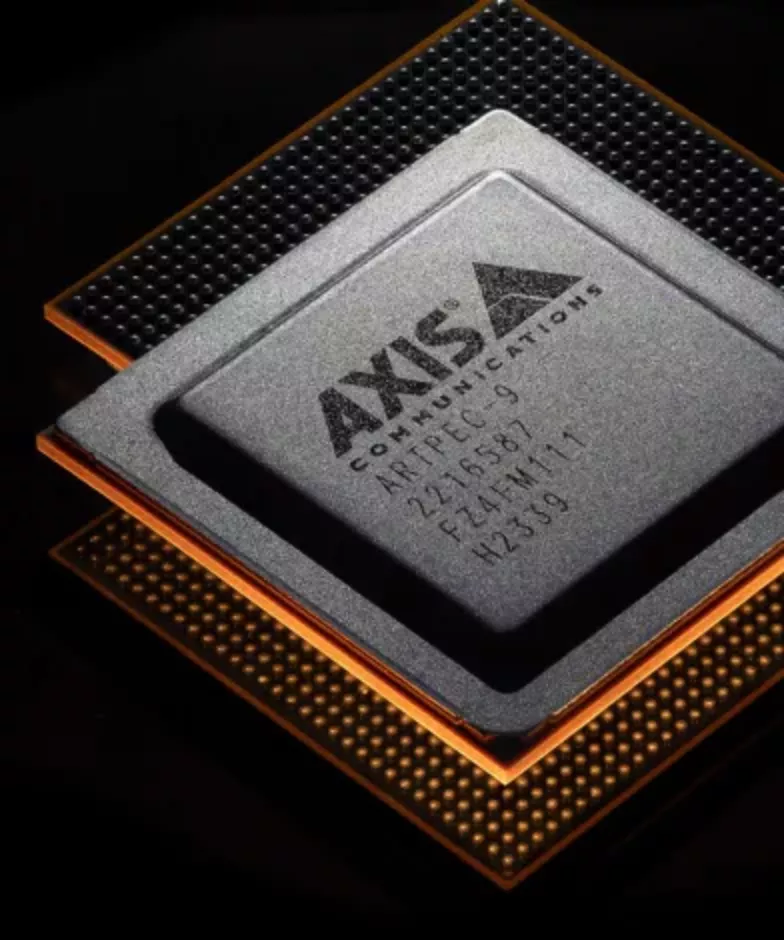

L'introduction d'ARTPEC-9, notre système sur puce (SoC) de dernière génération, marque une avancée significative dans le domaine de l'analyse en périphérie alimentée par l'IA. ARTPEC-9 améliore la détection d'objets et l'analyse d'événements, tout en offrant une vidéo de haute qualité grâce à un encodage AV1 efficace et des fonctionnalités de cybersécurité robustes.

Allègement de la charge d’analyse sur serveur

« Il y a 10 ans, les caméras de surveillance ne disposaient pas de la puissance de traitement nécessaire pour produire des fonctions d’analyse évoluées en périphérie de réseau. L’analyse gravitait donc naturellement autour des serveurs », signale Mats Thulin, Directeur du département des technologies fondamentales chez Axis Communications. « Or, même si la puissance de traitement d’un serveur est abondante, d’autres facteurs limitants interviennent. La compression de la vidéo avant son transfert de la caméra au serveur peut réduire la qualité des images analysées, et la montée en charge des solutions où sont exécutées toutes les fonctions d’analyse sur un serveur peut vite renchérir les coûts. »

En réalisant une classification avancée des objets en temps réel directement dans la caméra, nous nous appuyons sur plus de 20 ans d'expérience dans le développement de solutions d'analyse de pointe. Bien que l'analyse intégrée à la caméra ne soit pas une nouveauté, la combinaison d'une qualité d'image exceptionnelle et du deep learning crée une excellente plateforme pour améliorer les performances et les capacités d'analyse.

Réduire le recours à l'analyse basée sur serveur

« Il y a quelques années encore, les caméras de vidéosurveillance ne disposaient pas de la puissance de traitement nécessaire pour effectuer des analyses avancées à la périphérie du réseau, ce qui faisait de l'analyse basée sur serveur le choix par défaut », explique Mats Thulin. « Si la puissance de traitement des serveurs est encore largement disponible, plusieurs défis subsistent. Par exemple, la compression des vidéos avant leur transmission peut dégrader la qualité des images analysées. De plus, le fait de s'appuyer uniquement sur des analyses basées sur serveur ou sur le cloud lors de la mise à l'échelle des solutions peut entraîner des coûts importants, en particulier lorsque les exigences du système augmentent. »

Redéfinir l'analyse grâce à l'IA pour une efficacité et une précision inégalées

L'analyse basée sur l'IA est un processus très gourmand en ressources informatiques. Mats explique : « Lorsque l'analyse s'effectue uniquement sur des serveurs, la vidéo doit être encodée en périphérie, puis décodée avant de pouvoir être analysée, ce qui nécessite d'importantes ressources de traitement. La gestion de plusieurs flux vidéo, même dans un système relativement petit comprenant 20 à 30 caméras fonctionnant en haute résolution et à 20 ou 30 images par seconde, exige une puissance de traitement considérable. » Il poursuit : « La puissance de traitement de nos appareils périphériques, associée à leurs capacités avancées, a atteint un niveau tel que des analyses sophistiquées peuvent être intégrées aux caméras elles-mêmes. Ce passage à l'analyse périphérique réduit la dépendance aux solutions basées sur des serveurs et le cloud, permettant ainsi d'effectuer l'analyse au point de capture et de préserver la meilleure qualité d'image possible, un facteur crucial pour une analyse précise. »

“La puissance de traitement de nos appareils périphériques, ainsi que leurs capacités avancées, ont atteint un point où des analyses sophistiquées peuvent être intégrées dans les caméras elles-mêmes.”

Des images optimisées pour les machines et les humains

Les progrès réalisés en matière de qualité d'image tiennent compte du fait que les images sont de plus en plus « visionnées » par des machines plutôt que par des opérateurs humains. Cette distinction est importante, car les machines traitent les images différemment des humains.

« Nous pouvons désormais « ajuster » les images vidéo spécifiquement pour l'analyse basée sur l'IA afin d'obtenir de meilleurs résultats analytiques », explique Mats. « Par exemple, lorsque l'on ajuste une image pour l'œil humain », l'objectif est souvent de réduire le bruit pour une meilleure visibilité. Cependant, pour l'analyse par l'IA, la réduction du bruit est moins importante.

Amélioration de l'évolutivité du système grâce à des solutions hybrides

De plus, l'analyse en périphérie peut parfois réduire considérablement la quantité de données envoyées sur le réseau, ce qui se traduit par une utilisation plus efficace de la bande passante, du stockage et de la capacité des serveurs. Cela dit, l'analyse basée sur serveur continue de jouer un rôle important. Les approches hybrides qui combinent les atouts de l'analyse en périphérie avec des solutions basées sur serveur et sur le cloud constituent souvent la stratégie la plus efficace.

Les systèmes autonomes basés sur la périphérie continueront d'être précieux pour générer des événements basés sur des règles en temps réel à partir de la détection et de la classification d'objets. Cependant, Mats souligne qu'à mesure que les systèmes deviennent plus complexes, les solutions hybrides, qui exploitent à la fois l'analyse en périphérie et l'analyse sur serveur, sont susceptibles de devenir le choix privilégié pour les systèmes avancés.

Libérer la puissance des métadonnées

Dans le contexte de la vidéo, les métadonnées permettent essentiellement de marquer les éléments clés d'une scène, en ajoutant des descripteurs ou des informations sur ce qui se passe, plutôt que de simplement capturer des images brutes. Cette couche d'informations supplémentaire permet aux logiciels de gestion vidéo (VMS) de déclencher des actions en temps réel ou des recherches ciblées après l'événement, et de révéler des tendances et des modèles au fil du temps.