Grâce aux métadonnées, de nouveaux processus peut peuvent être créés et répondront aux besoins évolutifs des clients, non seulement dans le domaine de la sécurité, mais plus encore dans le secteur de la sécurité et de la digitalisation. Selon la devise : Make video more usable and searchable!

Métadonnées – qu’est-ce que c’est ?

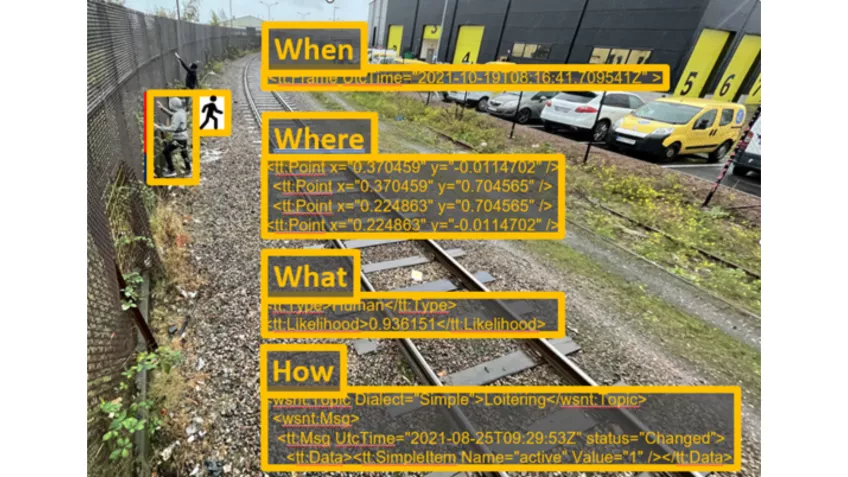

Les métadonnées sont des données sur d'autres données. Dans le domaine de la sécurité vidéo, les images peuvent être marquées par des métadonnées. Dans l'exemple suivant, nous pouvons voir que les informations relatives à l'heure, à la position dans la scène, au type d'objet détecté et à l'événement (flânerie) sont générées en tant que métadonnées.

Notez que les métadonnées peuvent être marquées d'une probabilité. Cette information sera transmise aux "utilisateurs" de ces métadonnées ; elle permet de filtrer les objets en fonction d’un niveau de confiance recherché.

Métadonnées – comment sont-elles produites ?

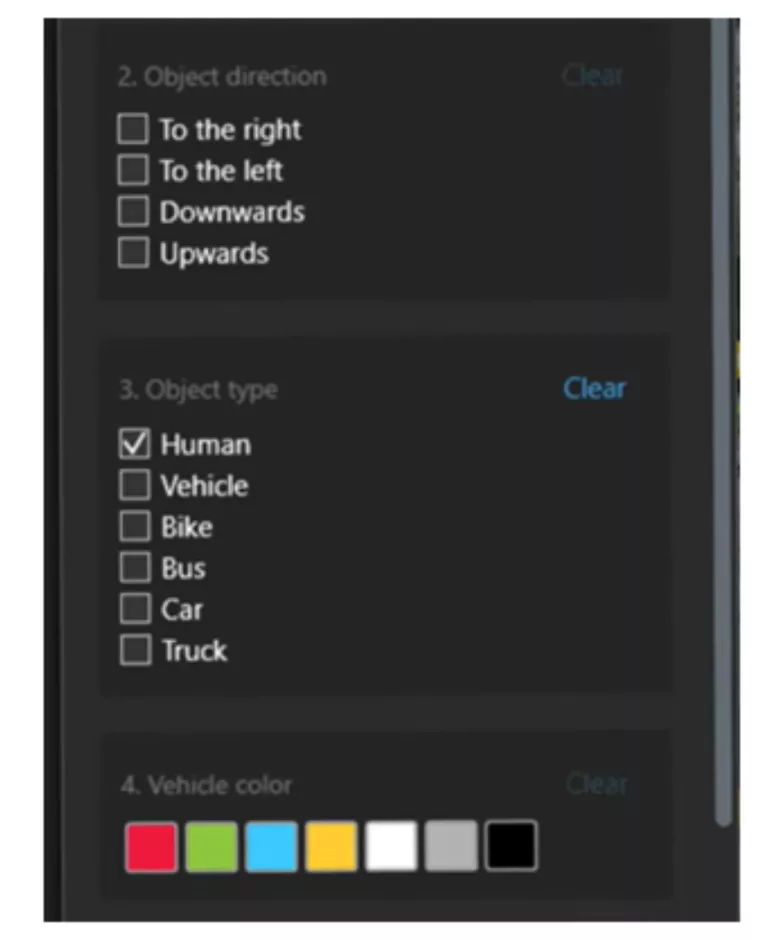

Grâce à l'IA, des modèles d’information sont entraînés (deep learning) à reconnaître différents types d'objets ou de situation. Ces objets reconnus génèrent les métadonnées correspondantes. Les objets classiques sont "humain", "véhicule" (ou un sous-ensemble comme "voiture", "camion"), plaque d'immatriculation. Le modèle peut également être entraîné à reconnaître les attributs de l'objet, tels que la couleur, et le comportement de l'objet, tel que la trajectoire (exemple "de la gauche") et toutes ces informations sont traduites en métadonnées. N'oubliez pas : Il existe une relation directe entre la complexité d'un cas d'utilisation et l'effort d'entraînement du modèle.

Une fois les modèles formés, l'algorithme qui en résulte génère constamment des métadonnées. La question pour l'"utilisateur" de la métadonnée est de savoir s'il a besoin d'être informé "image par image" ou au moyen d'une information "consolidée". Cette question doit être examinée au cas par cas. Dans la livraison "consolidée", la quantité de données envoyées au "consommateur" est considérablement réduite en ne fournissant des métadonnées que lorsque des objets sont présents dans la scène. De plus amples informations sont disponibles dans ce livre blanc.

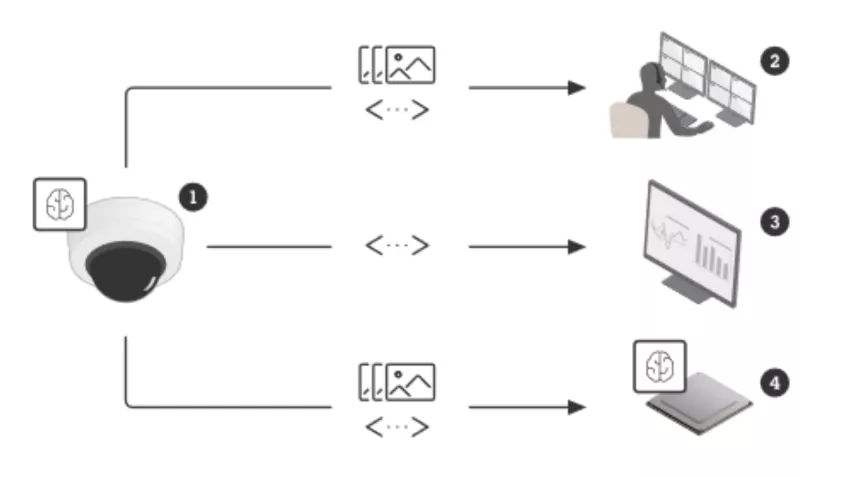

Grâce à l'évolution du matériel et à l'augmentation de la capacité de calcul des caméras, il est désormais possible d'exécuter des modèles d'IA entraînés, directement dans la caméra dans des "unités de traitement d'apprentissage profond" (Deep Learning Process Units DLPU). Ainsi, la génération de métadonnées a lieu "on the edge", c-à-d depuis les caméras, radars, etc. Les chipset Axis ARTPEC-8 (et ARTPEC-9 dès 2025) utilisent une DLPU. Les avantages du "Edge computing" ? Économiser les serveurs ! Analyser les images brutes (pas de compression) ! Permettre des événements en temps réel ! Et dans de nombreux cas, vous pouvez garantir la confidentialité et réduire le trafic réseau.

Où les métadonnées sont-elles consommées ?

Une fois les métadonnées produites, elles peuvent être utilisées directement par une application, exécutée de préférence dans le périphérique, pour les mêmes raisons que ci-dessus (vous avez probablement entendu parler d'AXIS Object Analytics) ou transmises à des utilisateurs tiers en tant que données d'entrée pour un traitement ultérieur.

Dans le cas de la transmission à des utilisateurs tiers, des standards ou normes ouverts, par exemple ONVIF-Profile M ou Axis Scene Metadata, et des protocoles, tels qu'une API ouverte, RTSP ou MQTT, facilitent une transmission et une intégration transparentes, y compris la possibilité de fusionner les données des capteurs dans le nuage pour une meilleure compréhension. Cela permet d'exploiter tout le potentiel de vos données.

Valeur ajoutée

Examinons maintenant les quatre principales façons d'utiliser les métadonnées :

- Directement dans la caméra :

Applications on the Edge. Outre les applications Axis telles que AXIS Object Analytics, nos partenaires d'intégration technologique proposent des applications embarquées dans les caméras. Par exemple, Aarani a entraîné ses modèles à détecter la fumée et les flammes. Dans les systèmes de gestion vidéo (VMS) pour permettre des réponses automatisées aux alertes et des recherches forensiques rapides en temps réel. L’illustration suivante montre un exemple de métadonnées que l'opérateur peut sélectionner dans le système de gestion vidéo pour rechercher efficacement des objets et des événements.

Source : Milestone Collectées dans des plateformes IoT et visualisées dans des tableaux de bord pour obtenir des informations et des statistiques.

Regardez les statistiques impressionnantes réalisées près d'Oslo par Edeva sur l'analyse des comportements de virage à gauche illégal (cliquez sur "Realtime data" pour une animation complète). La plateforme utilise les métadonnées d'un radar ("véhicule", "virage à gauche") et d'une caméra ("plaque d'immatriculation").

- Utilisation par les développeurs, en tant que données d'entrée pour les analyses de niveau supérieur, ce qui ajoute une deuxième couche de traitement. Il est également réaliste de former des modèles pour surveiller une certaine situation, par exemple pour le contrôle de la qualité. Lisez ici ce que le constructeur automobile BMW a développé à ce sujet. Pensez à des modèles spécialement formés pour analyser si un conteneur est vide, ou pour compter si le nombre requis de pièces dans un processus industriel est présent !

Perspectives - quelle est la prochaine étape ?

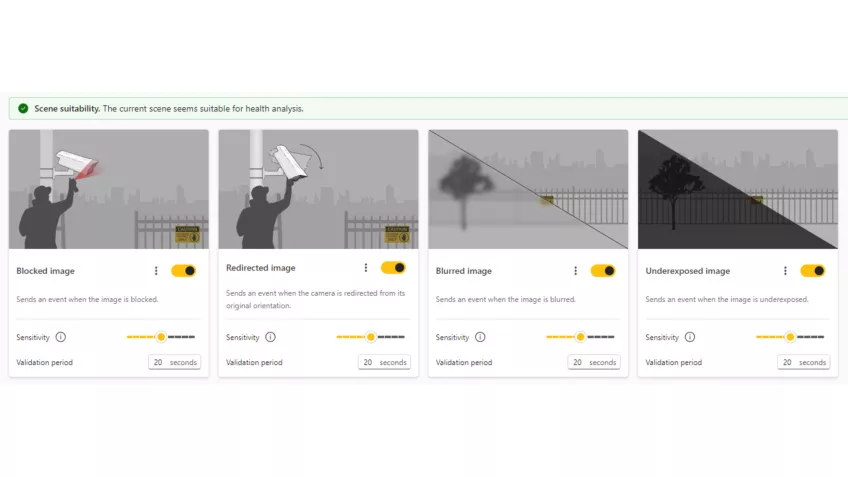

Dès maintenant : AXIS Image Health Analytics

Vérifiez si vos vidéos sont exploitables avant qu'il ne soit trop tard ! De nouvelles métadonnées permettent d'alerter en cas de dégradation de la qualité de l'image (floue ou sous-exposée) ou d'altération de la caméra (blocage ou redirection). L’application gratuite génère des événements Axis et est compatible ONVIF.

Futur proche :

Qu'en est-il de la combinaison des métadonnées et de l'IA générative (par exemple ChatGPT) ? Pensez à cette question, qu'un opérateur pourrait poser : "montrez-moi tous les véhicules de plombiers qui sont passés ce matin". Le moteur de recherche sélectionnerait rapidement les séquences vidéo en fonction des métadonnées "ce matin" et "véhicule", tandis que l'IA générative rechercherait dans les séquences sélectionnées les véhicules susceptibles d'appartenir à un plombier. À suivre !

Résumé - A retenir

- Les métadonnées sont générées à l'aide d'algorithmes d'intelligence artificielle entrainés spécifiquement. Elles permettent de rendre les recherches dans les vidéos plus efficaces.

- Le succès de l'analyse est directement lié à l'effort de formation sur le modèle. Pensez donc à des cas d'utilisation simples.

- L’exécution de ces analyses dans les périphériques (on the edge) est la méthode la plus efficace et la plus durable, grâce à des chipset puissants.

- Les métadonnées peuvent être utilisées directement dans les applications périphériques ou transmises à des tiers.

Dans cet esprit, restez à l’écoute des prochains développements. Continuons à planifier ensemble durablement des solutions utiles et intelligentes !

Bien à vous, Dominique Morel

Architect & Engineering Manager, Suisse & Autriche

📞 +41 79 780 72 37

✉️ Dominique.Morel@axis.com

🔗 XING | LinkedIn

PS : Si vous demandez à ChatGPT à quoi pourrait ressembler un véhicule de plombier :