L’exécution de fonctions d’analyse dans les caméras de surveillance n’est pas nouvelle. Néanmoins, plusieurs facteurs convergent en faveur d’une nouvelle génération de fonctions d’analyse locales, de plus en plus ouverte à l’imagination des développeurs : abaissement des seuils d’entrée pour les développeurs, la capacité de traitement toujours plus grande dans les caméras et le deep learning. Nous avons interrogé Mats Thulin, Directeur du département des technologies fondamentales chez Axis Communications, pour connaître son point de vue sur les avantages tangibles et les possibilités futures.

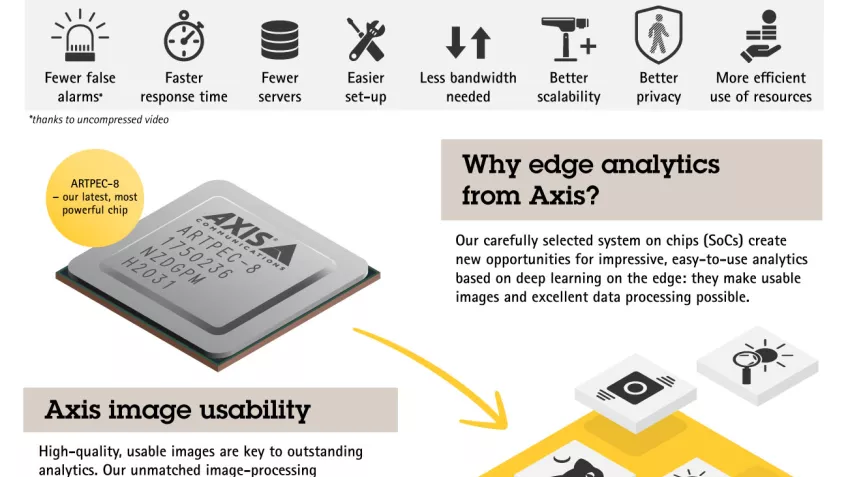

La sortie d’ARTPEC-8 , la toute dernière génération du système SoC (System-on-Chip) d’Axis, ouvre une nouvelle ère pour l’analyse deep learning en périphérie de réseau (EDGE). Pilotant des fonctions d’analyse comme la détection et la classification d’objets en temps réel dans la caméra elle-même, ARTPEC-8 cumule plus de 20 ans de développement.

Les fonctions d’analyse dans les caméras ne sont pas nouvelles : il y a plus de 10 ans, des caméras Axis intégraient déjà la détection de mouvement vidéo. Mais aujourd’hui, leur qualité d’image exceptionnelle et leurs méthodes embarquées de deep learning ont révolutionné les capacités d’analyse en local.

Allègement de la charge d’analyse sur serveur

« Il y a 10 ans, les caméras de surveillance ne disposaient pas de la puissance de traitement nécessaire pour produire des fonctions d’analyse évoluées en périphérie de réseau. L’analyse gravitait donc naturellement autour des serveurs », signale Mats Thulin, Directeur du département des technologies fondamentales chez Axis Communications. « Or, même si la puissance de traitement d’un serveur est abondante, d’autres facteurs limitants interviennent. La compression de la vidéo avant son transfert de la caméra au serveur peut réduire la qualité des images analysées, et la montée en charge des solutions où sont exécutées toutes les fonctions d’analyse sur un serveur peut vite renchérir les coûts. »

C’est notamment le cas lorsque l’analyse recourt au deep learning. M. Thulin précise : « Les fonctions d’analyse qui exploitent le deep learning mobilisent une puissance de traitement considérable. Lorsqu’elles tournent exclusivement sur des serveurs, il faut encoder puis décoder la vidéo, ce qui demande du temps supplémentaire avant le traitement du flux vidéo. Même dans un système relativement modeste comptant 20 à 30 caméras à 20 ou 30 images par seconde à haute résolution, le traitement de tous ces flux vidéo exige des ressources importantes. »

« La puissance et les capacités de traitement de nos dispositifs en périphérie du réseau sont désormais tellement performantes qu’on peut y faire migrer les fonctions d’analyse », ajoute M. Thulin. « Par ailleurs, la décentralisation des fonctions d’analyse dans les caméras elles-mêmes réduit le besoin d’analyses fortement consommatrices de ressources sur serveur ou dans le cloud. Mieux encore, cette réorganisation permet d’appliquer les fonctions d’analyse directement au point de capture de la vidéo, où la qualité d’image est la meilleure possible. »

Optimisation des images pour les machines et les humains

Les progrès dans la qualité d’image tiennent compte du fait que les images sont de plus en plus « observées » par les machines à la place des opérateurs humains. Il s’agit là d’une distinction importante, car les machines ne « voient » pas les images de la même manière que les humains.

« Nous pouvons désormais "adapter" les images vidéo à l’analyse par IA et les optimiser pour l’œil humain », explique M. Thulin. « Par exemple, l’adaptation d’une image à un opérateur humain passe généralement par une réduction du bruit. En revanche, pour l’analyse par IA, la réduction de bruit n’est pas aussi cruciale. Les objectifs de l’adaptation des images aux humains ou à l’analyse par IA sont différents, et par conséquent, utiliser les deux en parallèle aboutit à un résultat de meilleure qualité. »

Gains d’évolutivité du système

L’analyse en local peut réduire le volume de données transférées sur le réseau, avec à la clé des avantages en termes de bande passante, de stockage et de serveurs. Néanmoins, l’analyse sur serveur n’est pas pour autant vouée à disparaître. Loin de là. À terme, des méthodes hybrides exploitant les atouts de l’analyse en local et de l’analyse sur serveur et dans le cloud s’imposeront comme des solutions optimales.

« La répartition de la charge de traitement entre la périphérie de réseau et les serveurs produira des systèmes beaucoup plus évolutifs. En particulier, l’ajout d’une caméra dotée de capacités d’analyse en local évite d’avoir à augmenter la puissance de calcul des serveurs », illustre M. Thulin.

D’après M. Thulin, les systèmes indépendants en périphérie de réseau resteront utiles pour les applications d’analyse des scènes, en créant des alertes en temps réel basées sur la reconnaissance et la classification des objets, mais les solutions hybrides d’analyse locale et sur serveur gagneront du terrain pour les besoins de traitement avancé.

Une telle architecture est possible par le biais des métadonnées générées par les fonctions d’analyse locale aux côtés des images vidéo. Dans le contexte de la vidéo, les métadonnées servent essentiellement à repérer les éléments d’une scène. En d’autres termes, elles ajoutent des descripteurs ou des renseignements sur la scène, en plus de la vidéo brute de la scène. Le logiciel de gestion vidéo (VMS) peut exploiter les métadonnées pour agir en fonction de la scène, en déclenchant des actions en temps réel ou après événement, en recherchant des éléments d’intérêt ou en exécutant des analyses complémentaires.

Protection de la vie privée

L’analyse en périphérie de réseau comporte des avantages susceptibles de maintenir la confidentialité en plus de ceux liés à la sécurité, à la protection et aux opérations. Par exemple, les fonctions de comptage de personnes en local, utiles dans un environnement commercial, ont seulement à envoyer les données de la caméra au lieu des images vidéo.

Cependant, l’analyse en périphérie de réseau peut également protéger la confidentialité même lors du transfert d’images vidéo.

« Le masquage intelligent, qui floute les visages des personnes d’une scène, préserve la vie privée. Le transfert en parallèle du flux vidéo d’origine, consultable uniquement si nécessaire, signifie qu’en cas d’incident, la vidéo non masquée reste accessible aux opérateurs », souligne M. Thulin.

Nouvelles opportunités en termes d’applications de vision artificielle

En parallèle au renforcement des capacités des dispositifs pilotés par ARTPEC-8, les améliorations à la plateforme ACAP (Axis Camera Application Platform) permettent de diversifier les profils des développeurs en leur offrant des environnements familiers pour créer des applications de vision artificielle. Aujourd’hui parvenue à sa quatrième génération, la plateforme ACAP inclut des API et des cadres technologiques standardisés, ainsi qu’une prise en charge des langages de programmation à haut niveau d’abstraction.

« Les évolutions de la plateforme ACAP version 4 permettent d’attirer des partenaires de développement venant d’autres horizons que les secteurs traditionnels de la surveillance », constate M. Thulin. « ACAP repose sur des composants familiers en source ouverte pour les développeurs issus du monde du cloud ou des serveurs. Nous soutenons les spécifications des métadonnées ONVIF qui favorisent un environnement ouvert, où les développeurs peuvent créer des architectures hybrides avec plusieurs produits compatibles ONVIF. Il s’agit là d’un facteur décisif pour la création de systèmes et architectures hybrides qui fonctionnent. »

L’évolution des capacités analytiques de détection profite également aux développeurs et innovateurs en sécurité issus de secteurs plus variés.

« Les progrès dans la détection des objets, où les caméras développent une compréhension toujours plus fine du contexte d’une scène en distinguant par exemple une rue, une pelouse ou un parking, nous aideront à créer des fonctions d’analyse plus précises des scènes et des objets qu’elles comportent. Ces informations vont ouvrir un nouveau chapitre en termes d’innovation », anticipe M. Thulin. « Pour nos partenaires, pour les développeurs qui s’orientent vers les applications de vision artificielle et, bien sûr, pour nos clients, ce nouveau potentiel pour l’analyse en périphérie de réseau est considérable. »