감시 카메라에서 실행되는 분석은 새로운 주제는 아니지만, 개발자를 위한 낮은 문턱, 처리 능력이 뛰어난 강력한 카메라, 그리고 딥 러닝의 조합은 에지에서 실행되는 분석 애플리케이션의 새로운 세대를 여는 데 혁신을 가져옵니다. 그 한계는 개발자의 상상력에 달려있을 뿐입니다. Axis Communications 핵심 기술 부문 디렉터 Mats Thulin과의 인터뷰를 통해 현재와 미래에서의 이점에 대해 알아보았습니다.

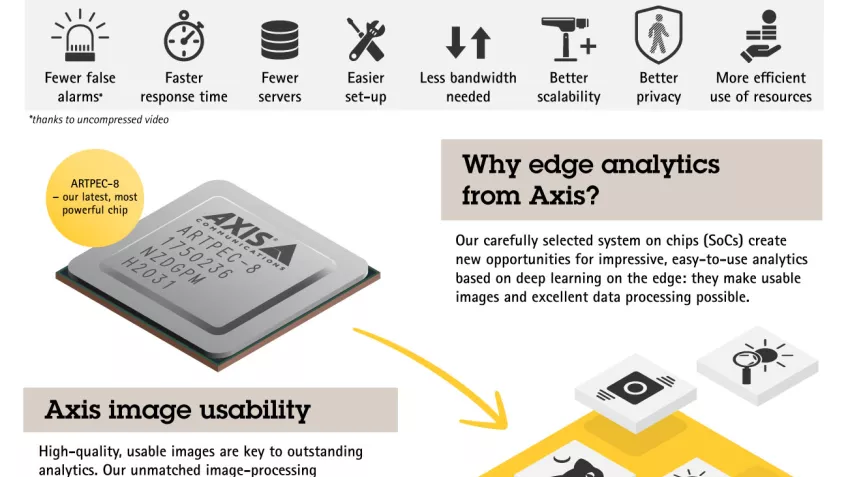

Axis 시스템 온 칩(SoC)의 새로운 세대인 ARTPEC-8의 등장은 네트워크 에지에서 구현되는 딥 러닝 분석의 새로운 시대를 열었습니다. 카메라 자체에서 실시간 객체 감지 및 분류와 같은 분석 기능을 제공하는 ARTPEC-8은 20년 이상의 개발 경험이 수렴된 결과물입니다.

카메라에서 실시간 분석은 새로운 것이 아니었지만, 엣지에서 실행되는 분석을 위한 이미지 품질과 딥 러닝의 조합은 분석 기능에 대한 변혁을 가져왔습니다.

서버의 분석 부담 감소

Axis Communications 핵심 기술 부문 디렉터 Mats Thulin은 "10년 전, 감시 카메라는 네트워크의 에지에서 고급 분석을 제공하는데 필요한 충분한 처리 능력이 없었기 때문에, 서버 기반 분석이 자연스러운 흐름이었습니다"라고 말합니다. "하지만 서버의 처리 능력은 풍부하지만 다른 요인들이 도전을 제기할 수 있습니다. 카메라에서 서버로 전송되기 전에 비디오 이미지를 압축하면 분석되는 이미지의 품질이 저하될 수 있고, 모든 분석이 서버에서 이루어지는 솔루션을 확장하는 것은 비용이 많이 드는 작업이 될 수 있습니다."

특히 딥 러닝이 분석에 사용될 때 더욱 그렇습니다. Mats는 계속합니다. "딥 러닝을 사용하는 분석은 계산 집약적인 작업입니다. 서버에서 순수하게 실행될 때는 비디오를 인코딩한 다음 디코딩해야 스트림을 처리할 수 있는데, 이 작업을 수행하려면 추가적인 시간이 걸립니다. 초당 20~30프레임의 고해상도 카메라 2~30대 규모의 상대적으로 작은 시스템에서도, 다수의 비디오 스트림을 처리하려면 상당한 리소스가 필요합니다."

"Axis 에지 장치의 처리 능력과 기능이 이제 분석 기능을 다시 에지로 마이그레이션하는 데 적합한 수준에 도달했습니다"라고 그는 덧붙입니다. "그리고 카메라 자체에서 더 많은 분석을 수행하면 컴퓨팅 집약적인 서버 기반 및 클라우드 기반 분석의 필요성이 줄어듭니다. 중요한 것은 분석이 이미지 캡처 지점에서 적용되기 때문에, 가장 높은 이미지 품질을 사용해 분석할 수 있다는 점입니다."

기계와 인간을 위한 최적화된 이미지

이미지 품질의 발전은 이미지가 점점 더 인간 운영자 대신 기계에 의해 '보게 되는' 사실을 고려합니다. 여기에는 중요한 차이점이 있습니다. 기계는 인간과 같은 방식으로 이미지를 보지 않기 때문입니다.

"우리는 이제 인간의 눈에 최적화할 뿐만 아니라 AI 분석을 위해 비디오 이미지를 '조정'할 수 있습니다"라고 그는 설명합니다. "예를 들어 운영자를 위해 이미지를 조정할 때는 보통 노이즈 감소를 목표로 합니다. 하지만 AI 분석을 위해서는 노이즈 감소가 필요하지 않습니다. 인간을 위한 이미지 조정과 AI 분석을 위한 이미지 조정의 목표는 다르기 때문에, 이 둘을 병행하여 사용하면 더 높은 품질의 결과를 얻을 수 있습니다."

시스템 확장성 향상

에지에서 분석을 수행하면 네트워크를 통해 전송되는 데이터의 양을 줄여 대역폭, 저장 공간, 서버에 대한 효율성을 창출할 수 있습니다. 그렇다고 서버 기반 분석이 여전히 수행해야 할 역할이 없은 아닙니다. 이와는 거리가 멉니다. 궁극적으로 에지 분석과 서버 및 클라우드 기반의 분석의 강점을 활용하는 하이브리드 접근법이 최적의 솔루션이 될 것입니다.

"에지와 서버가 처리 부하를 공유하면 시스템의 확장서이 훨씬 높아집니다. 에지 분석 기능을 갖춘 새로운 카메라를 추가하면 서버 처리 능력을 높일 필요가 없기 때문입니다" 라고 Mats는 설명합니다.

단독형 에지 기반 시스템은 장면 분석 애플리케이션(객체 인식 및 분류를 기반으로 실시간 경보를 생성)에서 계속 사용될 것이지만, 고급 처리 요구 사항을 위한 하이브리드 서버 및 에지 분석 솔루션이 점점 더 지배적이 될 것이라고 Mats는 믿고 있습니다.

이는 비디오 이미지와 함께 에지 분석으로 생성된 메타데이터에 의해 가능합니다. 비디오의 맥락에서 메타데이터는 기본적으로 장면의 요소에 태그를 지정합니다. 즉, 장면'의' 원본 비디오 영상이 아니라, 장면에 '대한' 설명자나 인텔리전스를 추가합니다. 비디오 관리 소프트웨어(VMS)는 메타데이터를 사용해 장면에 대해 실시간으로 또는 후속 이벤트에서 조치를 취하도록 액션을 트리거할 수 있을 뿐만 아니라 관심 있는 요소를 검색하거나 추가 분석을 수행할 수 있습니다.

개인 정보 보호

에지 분석은 개인 정보 보호를 지원하는 데 도움이 되면서도 보안, 안전 및 운영 이점을 제공할 수 있습니다. 예를 들어 리테일 환경에서 유용한 에지 기반 인원 계수 분석 솔루션은 비디오 이미지 대신 카메라의 (메타)데이터만 전송하기만 하면 됩니다.

하지만 에지 기반 분석은 비디오 이미지가 전송될 때에도 개인 정보를 보호하는 데도 도움이 될 수 있습니다.

"지능형 마스킹을 통해 장면에 있는 사람의 얼굴을 흐리게 처리함으로써 개인 정보를 보호할 수 있습니다. 필요한 경우에만 볼 수 있는 원본 스트림을 따로 보낼 수 있으므로, 사건이 발생한 경우 운영자가 마스킹되지 않은 비디오에 여전히 액세스할 수 있습니다"라고 Mats는 말합니다.

컴퓨터 비전 애플리케이션의 새로운 세계

ARTPEC-8 기반 하드웨어의 능력 향상과 함께, Axis Camera Application Platform(ACAP)의 개선 사항은 좀 더 광범위한 개발자 그룹에게 컴퓨터 비전 애플리케이션을 만드는 기회를 제공합니다. ACAP는 이제 4세대에 이르렀으며, 업계 표준 API 및 프레임워크, 높은 수준의 프로그래밍 언어 지원을 포함하고 있습니다.

"ACAP 버전 4의 변경 사항으로 인해 전통적인 감시 섹터에서 아닌 배경의 개발 파트너가 증가하고 있다는 사실을 목도하고 있습니다" Mats는 확인했습니다. "ACAP는 클라우드나 서버 배경의 개발자에게 친숙한 구성 요소를 기반으로 합니다. 우리는 ONVIF 메타데이터 사양을 준수하여 개발자가 서로 다른 ONVIF 규격 제품과 함께 하이브리드 아키텍처를 만들 수 있는 개방형 환경을 추구하고 있습니다. 이것이 하이브리드 시스템과 아키텍처가 작동하는 데 필수적인 핵심 요소 중 하나입니다."

분석 감지 기능의 발전은 보안 개발자 및 보다 넓은 섹터의 혁신가에게도 도움이 되고 있습니다.

"객체 감지의 발전은, 카메라가 장면의 맥락을 이해(예: 도로, 잔디밭, 주차장을 구분)하는 능력이 향상되는 것과 더불어, 장면과 그 안에 있는 다른 객체에 대한 보다 정확한 분석을 구현하는 데 도움이 될 것입니다. 이러한 지식은 또 다른 수준의 혁신을 가져올 것입니다"라고 Mats는 말합니다. "에지 분석의 새로운 잠재력은 거대합니다. 우리의 기존 파트너, 컴퓨터 비전 애플리케이션을 처음 접하는 개발자, 그리고 물론, 우리의 고객 모두에게 큰 가능성을 가져올 것입니다."