Embora a integração da análise nas câmaras de vigilância não seja nova, a redução das barreiras de acesso a programadores, a elevada resiliência das câmaras, o seu poder de processamento e o aparecimento do deep learning abriram as portas a uma nova geração de análises, onde o único limite é a imaginação dos programadores. Falámos com Mats Thulin, Diretor de Core Technologies da Axis Communications, para conhecer a sua opinião sobre os benefícios tanto agora como para o futuro.

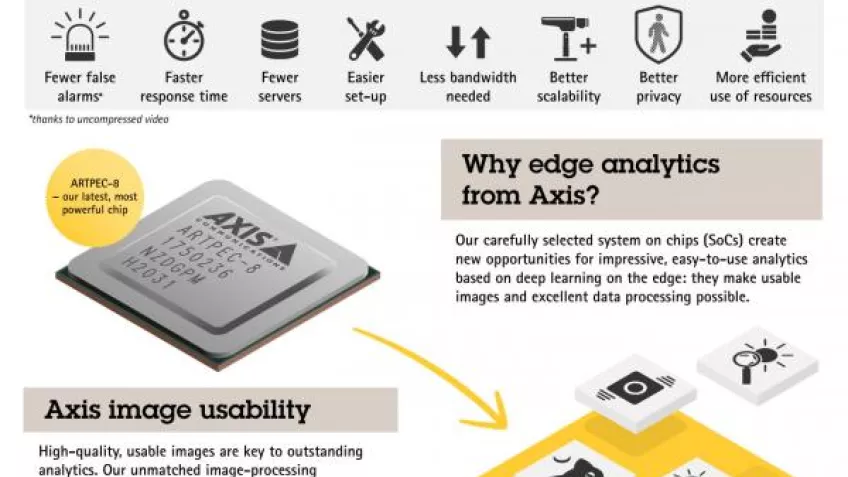

A chegada do ARTPEC-8, a nova geração do sistema em chip (SoC) da Axis, marca o início de uma nova era na análise com a utilização de deep learning profunda no extremo da rede. Capaz de realizar operações de análise como a deteção e classificação de objetos em tempo real dentro da própria câmara, o ARTPEC-8 é fruto de mais de 20 anos de evolução.

Embora a análise na câmara não seja um conceito novo, uma vez que a deteção de movimento em vídeo já fazia parte das câmaras Axis há mais de dez anos, a combinação de qualidade de imagem superior e deep learning transformou as possibilidades da análise.

Reduzir o peso das análises no servidor

"Há uma década, as câmaras de vigilância não tinham o poder de processamento para fornecer análises avançadas no extremo da rede, forçando alguma confiança nas análises baseadas em servidores", recorda Mats Thulin, Diretor de Core Technologies da Axis Communications. "No entanto, embora o servidor tenha muito poder de processamento, existem outros fatores que podem representar desafios. A compressão de imagens de vídeo antes de as transferir da câmara para o servidor pode reduzir a qualidade das imagens a serem analisadas e adaptar soluções para que todas as análises tenham lugar num servidor possam ser proibitivamente dispendiosas.

Um exemplo deste problema é a utilização de deep learning na área da análise. Thulin acrescenta: "A análise em deep learning é uma tarefa de computação-intensiva. Se o executar apenas em servidores, tem de codificar e descodificar o vídeo, o que leva mais tempo antes de poder processar o fluxo. O processamento de diferentes fluxos de vídeo, mesmo num sistema relativamente pequeno com 20-30 câmaras a 20 ou 30 fotogramas por segundo e em alta resolução, requer muitos recursos".

"O poder de processamento e as capacidades dos nossos dispositivos no extremo já são tão elevados que nos permitem reintegrar as funções analíticas", acrescenta. "E com mais capacidades analíticas na câmara, não há necessidade de soluções analíticas na nuvem ou em servidores que necessitam de grande consumo de energia. Além disso, a análise é aplicada às imagens no ponto de captação, assegurando a mais alta qualidade de imagem possível".

Imagens otimizadas para máquinas e humanos

A evolução na qualidade de imagem tem em conta o facto de existirem cada vez mais máquinas em vez de operadores humanos a visualizar imagens, uma distinção muito pertinente, uma vez que as máquinas não vêem as imagens da mesma forma que os seres humanos.

"Agora podemos ajustar as imagens de vídeo para análise da IA e também otimizá-las para o olho humano", explica Thulin. "Por exemplo, ao ajustar uma imagem para um operador, a ideia é normalmente a de reduzir o ruído. Contudo, no caso da análise da IA, a redução do ruído não é tão essencial. Ao ajustar a imagem, os objetivos dependem se é para análise de IA ou para o olho humano, por isso se usar ambos os sistemas em paralelo obterá um resultado de maior qualidade."

Escalabilidade melhorada no sistema

A análise no limite pode reduzir a quantidade de dados enviados através da rede, para melhorar a eficiência em termos de largura de banda, armazenamento e servidores. Contudo, isto não significa que a análise baseada em servidores já não tenha um papel a desempenhar - longe disso. No final, os modelos híbridos que aproveitam as vantagens da análise de borda e da análise baseada em servidores e nuvens serão sem dúvida a melhor solução.

"Ao partilhar a carga de processamento entre o dispositivo local e o servidor, os sistemas serão muito mais escaláveis, pois será possível adicionar uma nova câmara com funções analíticas no limite sem ter de expandir o poder de processamento do servidor", explica Thulin.

Enquanto que os sistemas autónomos de extremo vão continuar a ser utilizados em aplicações analíticas de cena, para criar alertas em tempo real baseados no reconhecimento e classificação de objetos, Thulin acredita que as soluções híbridas de analíticas no servidor e no extremo vão tornar-se cada vez mais importantes em ambientes que exijam maior poder de processamento.

A razão para isto são os metadados gerados pela análise no extremo em conjunto com as imagens de vídeo. Os metadados, no contexto do vídeo, basicamente rotulam os elementos de uma cena. Por outras palavras, acrescentam descritores ou informações sobre a cena, em vez de apenas imagens de vídeo em bruto da cena. O software de gestão de vídeo (VMS) pode utilizar os metadados para agir em resposta à cena e desencadear ações em tempo real ou após um evento, bem como pesquisar itens de interesse ou realizar novas análises.

Proteção da privacidade

Outra vantagem da análise no extremo é que pode ajudar a proteger a privacidade, bem como proporcionar segurança ou benefícios operacionais. Por exemplo, a análise no extremo para a contagem de pessoas, que é muito útil em ambientes comerciais, necessitará apenas de transferir dados de câmaras em vez de imagens de vídeo.

Não obstante, as análises no extremo podem proteger a privacidade mesmo durante a transferência de imagens de vídeo.

"A aplicação inteligente de máscaras, que esconde os rostos das pessoas numa cena, assegura a privacidade. E porque as filmagens originais são enviadas separadamente, e só são reproduzidas quando necessário, no caso de um incidente os operadores têm a opção de aceder ao vídeo sem as máscaras", explica Thulin.

Um novo mundo de aplicações de visão artificial

Para além das novas capacidades do hardware controlado pelo chip ARTPEC-8, melhorias na Plataforma de Aplicação da Câmara AXIS (ACAP) colocam ao alcance de mais programadores a oportunidade de criar aplicações de visão artificial nos campos que já dominam. A ACAP, agora na sua quarta geração, inclui APIs e arquiteturas padrão da indústria, e suporta linguagens de programação de alto nível.

"Graças às alterações introduzidas na versão 4 do ACAP, temos cada vez mais parceiros de desenvolvimento de sectores fora da vigilância tradicional", confirma Thulin. "O ACAP é construído com componentes de código aberto que são muito populares entre os programadores habituados a trabalhar com ambientes de nuvem ou de servidor. Adaptamos as especificações dos metadados ONVIF a um ambiente aberto, onde os criadores podem criar arquiteturas híbridas com diferentes produtos compatíveis com ONVIF. Esta é uma das chaves para fazer com que os sistemas e arquiteturas híbridas realmente funcionem.”

A melhoria das capacidades analíticas de deteção também abriu mais portas para os criadores de soluções de segurança e para os pioneiros noutros sectores.

"Os avanços na deteção de objetos, com câmaras que compreendem cada vez mais o contexto de uma cena, permitem-nos diferenciar entre uma rua, um jardim ou um parque de estacionamento, por exemplo, para que possamos aplicar uma análise mais precisa a cada cena e aos objetos que a compõem. Esta informação irá elevar a fasquia da inovação", diz Thulin. "O novo potencial de análise no extremo é enorme - para os nossos parceiros existentes, para programadores sem experiência prévia com aplicações de visão mecânica, e claro, para os nossos clientes.”